在当今数字化的时代,官网系统的搜索引擎抓取效率至关重要。FastAdmin 作为一款功能强大的开发框架,在批量生成文章方面有着显著优势。然而,要让这些批量生成的文章能被搜索引擎更好地抓取和收录,就不得不考虑 robots 协议的适配问题。

FastAdmin 批量生成文章为网站内容的快速填充提供了便利,但如果没有正确适配 robots 协议,可能会导致搜索引擎无法正常抓取这些文章,影响网站的搜索引擎优化(SEO)效果。Robots 协议是一种约定,用于告知搜索引擎哪些页面可以抓取,哪些页面需要屏蔽。在使用 FastAdmin 批量生成文章时,我们需要确保生成的文章在 robots 协议的规则下能够被搜索引擎顺利抓取。

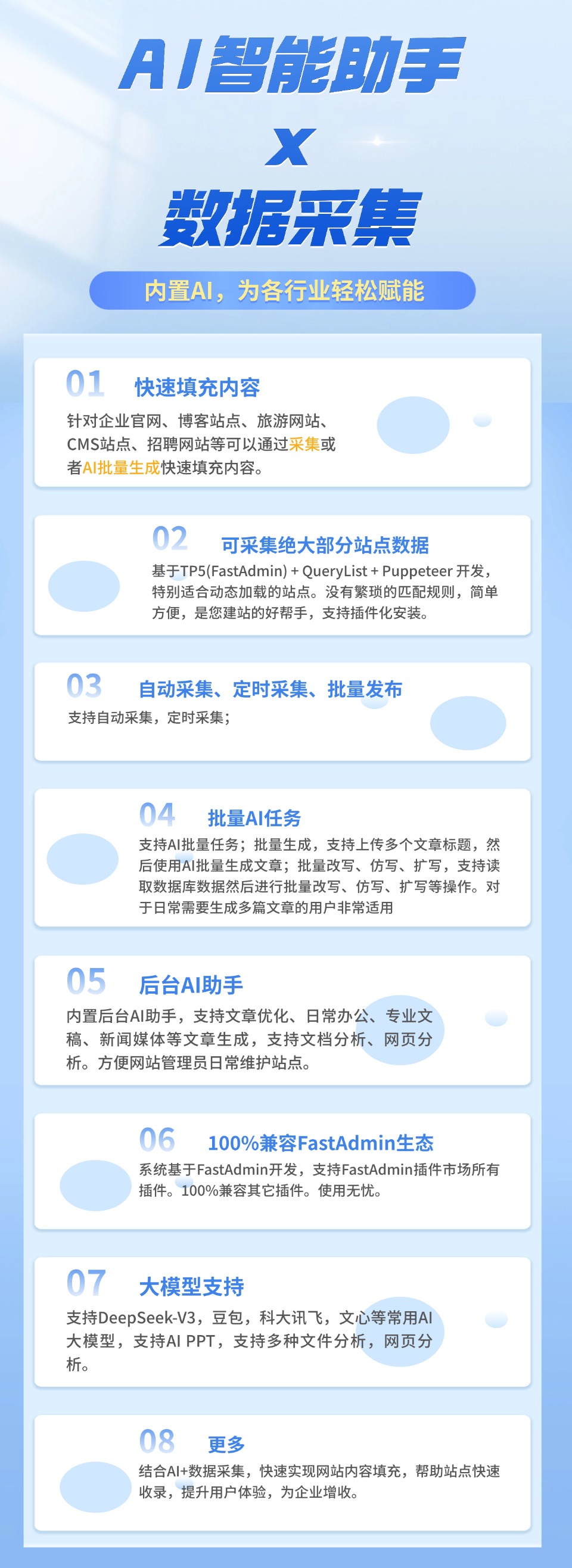

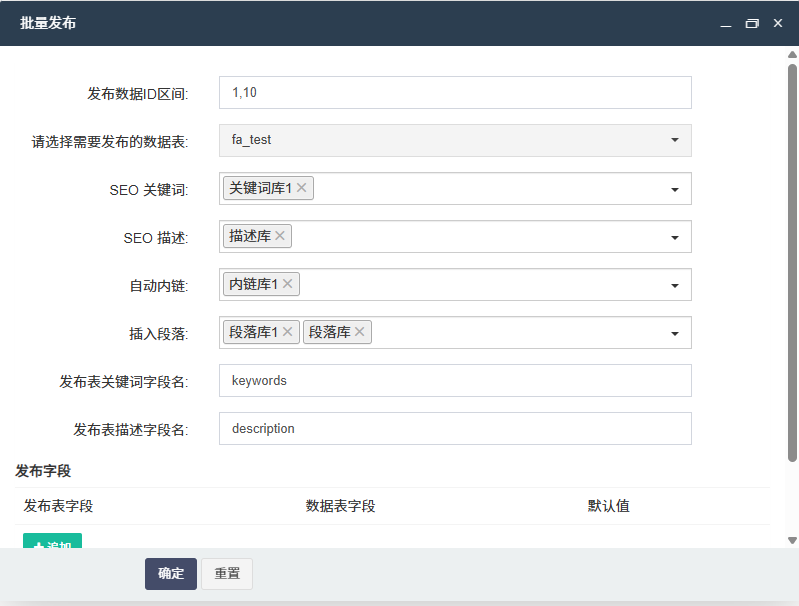

首先,我们要明确 FastAdmin 批量生成文章的特点。它能够快速生成大量的文章内容,并且可以根据预设的模板和规则进行定制。但这些文章在生成后,需要在网站的目录结构和 URL 规则上进行合理规划,以便与 robots 协议相适配。例如,我们可以将批量生成的文章放置在特定的目录下,并为其设置清晰的 URL 格式,这样在编写 robots 协议文件时就能更加明确地指定哪些文章可以被抓取。

其次,编写合适的 robots 协议文件是关键。在 robots 协议文件中,我们需要准确地指定搜索引擎可以访问的目录和页面。对于 FastAdmin 批量生成的文章,我们可以通过设置允许访问的规则,让搜索引擎能够顺利抓取这些文章。同时,也要注意屏蔽一些不必要的页面,如临时文件、测试页面等,以提高搜索引擎的抓取效率。在编写 robots 协议文件时,要使用标准的语法和格式,确保搜索引擎能够正确解析。

另外,还需要考虑不同搜索引擎对 robots 协议的支持情况。虽然大多数搜索引擎都遵循标准的 robots 协议,但在一些细节上可能会存在差异。因此,在进行 robots 协议适配时,要对主要的搜索引擎进行测试,确保 FastAdmin 批量生成的文章在各个搜索引擎上都能被正常抓取。

此外,定期检查和更新 robots 协议文件也是必不可少的。随着网站内容的不断更新和变化,FastAdmin 可能会生成新的文章或对原有文章进行修改。这时,我们需要及时调整 robots 协议文件,以保证搜索引擎能够准确地抓取最新的文章内容。

综上所述,官网系统搜索引擎抓取中,FastAdmin 批量生成文章的 robots 协议适配是一个重要的环节。通过合理规划文章的目录结构和 URL 规则、编写合适的 robots 协议文件、考虑不同搜索引擎的差异以及定期检查更新等措施,能够确保 FastAdmin 批量生成的文章被搜索引擎高效抓取,从而提升网站的 SEO 效果和用户体验。

后台体验地址:https://demo.gzybo.net/demo.php

移动端体验地址:https://demo.gzybo.net/wx

账号:demo

密码:123456

联系我们

发表评论 取消回复