随着人工智能技术的普及,越来越多开发者和中小企业希望以低成本部署AI生成系统。通过免费/开源AI模型整合,结合高效后台框架FastAdmin,可实现快速、稳定且经济的解决方案。本文将详细介绍如何利用这一组合,在不牺牲性能的前提下,最大限度降低开发与运维成本。

在当前AI应用爆发式增长的背景下,使用免费/开源AI模型整合成为极具吸引力的选择。这些模型如Stable Diffusion、Llama系列、Whisper等,均提供开放权重和完整代码,允许用户自由部署和二次开发。而FastAdmin作为基于ThinkPHP和Layui的快速开发后台框架,以其模块化设计和丰富的插件生态,成为集成AI功能的理想平台。通过将二者结合,开发者无需从零构建权限管理、数据接口或前端界面,大幅缩短项目周期。

具体实施的第一步是环境准备。建议使用Linux服务器(如Ubuntu 20.04)并配置Nginx + PHP 7.4+ + MySQL 5.7以上版本,确保FastAdmin正常运行。随后,通过Composer安装FastAdmin核心系统,并完成基础配置。接下来,重点在于接入免费/开源AI模型。以文本生成为例,可选择部署本地化的ChatGLM-6B或Phi-3-mini模型,借助Hugging Face提供的推理API或本地Ollama服务进行调用。通过FastAdmin的自定义接口功能,创建RESTful路由将前端请求转发至AI服务端口,实现无缝对接。

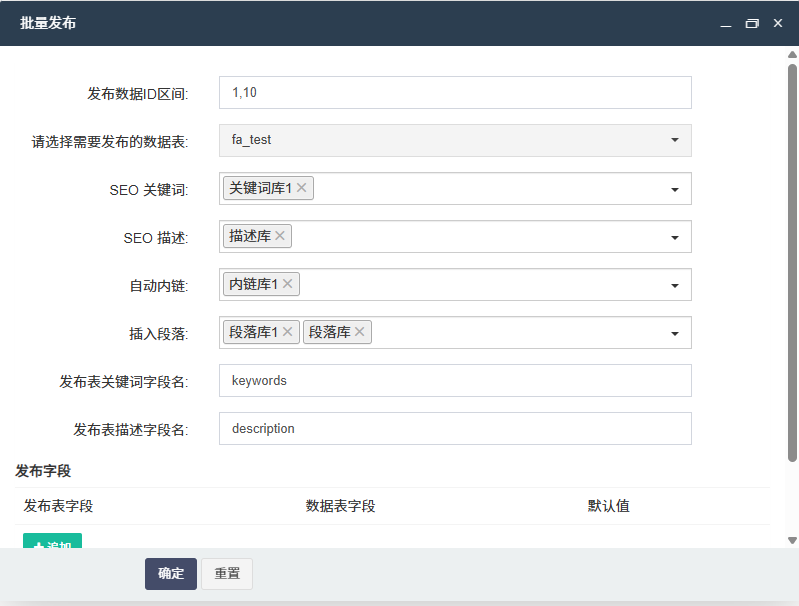

为提升系统稳定性,建议采用异步任务机制处理AI生成请求。例如,集成Supervisor管理Python后台进程,并使用Redis作为消息队列,避免高延迟影响用户体验。同时,可在FastAdmin中新增“AI任务管理”模块,用于监控生成状态、记录日志及设置失败重试策略。这种架构不仅提升了响应效率,也便于后期维护与扩展,充分体现了免费/开源AI模型整合在实际生产中的可行性。

安全性同样不可忽视。由于AI接口可能暴露敏感信息或被滥用,需在FastAdmin中启用JWT鉴权,并对AI调用频率进行限流。此外,建议对输入内容做关键词过滤和长度校验,防止恶意注入或资源耗尽攻击。对于涉及用户数据的场景,应确保模型本地部署,避免使用第三方云服务,从而保障数据隐私——这也是选择免费/开源AI模型整合的一大优势:完全掌控数据流向。

最后,优化成本的关键在于资源调度。可通过Docker容器化部署多个轻量级AI模型,配合Nginx反向代理实现负载均衡。例如,将图像生成、文本摘要、语音转写分别封装为独立服务,按需启动,减少内存占用。同时,利用FastAdmin的可视化配置功能,管理员可随时切换模型版本或调整参数,无需修改代码。整个系统几乎零 licensing 费用,仅需承担基础云服务器开支,真正实现以最低成本搭建生成系统。

综上所述,通过免费/开源AI模型整合与FastAdmin的深度协同,开发者能够快速构建功能完备的AI生成平台。无论是内容创作、智能客服还是自动化报告生成,该方案都展现出极高的性价比与灵活性。未来,随着更多高性能轻量模型的发布,这一模式将进一步降低AI应用门槛,推动技术普惠化进程。掌握这项技能,意味着你已站在低成本智能化转型的前沿阵地。

后台体验地址:https://demo.gzybo.net/demo.php

移动端体验地址:https://demo.gzybo.net/wx

账号:demo

密码:123456

联系我们

发表评论 取消回复