随着人工智能技术广泛应用,AI内容的“价值观对齐”难题日益凸显。如何确保生成内容符合社会主流价值、避免传播不当信息,成为开发者与平台运营者必须面对的核心挑战。特别是在使用如FastAdmin这类高效后台管理系统时,集成有效的“内容红线过滤器”显得尤为重要。

AI内容的“价值观对齐”难题源于模型训练数据的多样性和复杂性。尽管大模型具备强大的语言生成能力,但其输出可能无意中包含歧视性言论、敏感话题或违法不良信息。若缺乏有效监管机制,这些内容一旦发布,将对品牌形象、用户安全乃至社会稳定造成负面影响。因此,在系统层面构建内容审核机制,尤其是通过技术手段实现自动拦截,是解决AI内容的“价值观对齐”难题的关键路径之一。

FastAdmin作为一款基于ThinkPHP开发的开源后台框架,以其灵活的插件机制和丰富的API接口广受开发者青睐。利用其扩展能力,我们可以在内容提交环节嵌入“内容红线过滤器”,实现对用户输入或AI生成文本的实时筛查。具体实现方式包括:配置关键词黑名单、调用第三方敏感词检测服务(如阿里云内容安全API),或结合正则表达式匹配高风险语义模式。通过这些手段,系统可在数据入库前完成初步过滤,有效防范违规内容传播。

值得注意的是,仅依赖静态关键词匹配难以应对语义变体或上下文隐含的不当意图。例如,“价值观对齐”本身是一个中性术语,但在特定语境下可能被恶意曲解。因此,AI内容的“价值观对齐”难题要求过滤策略具备一定智能判断能力。开发者可在FastAdmin中集成轻量级NLP模型,对文本情感倾向、主题类别进行分析,辅助决策是否放行。这种“规则+模型”的双层过滤架构,既能保证效率,又能提升识别准确率。

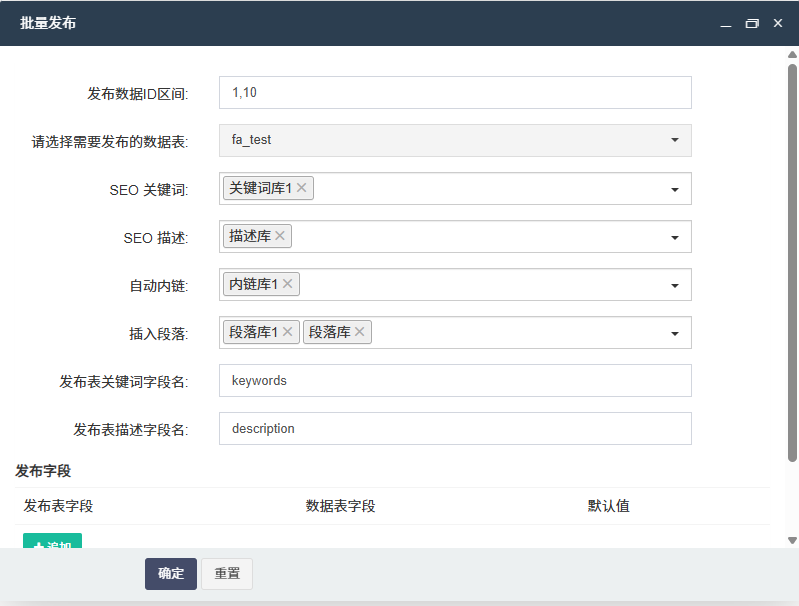

此外,为保障系统的可维护性与适应性,建议将“内容红线过滤器”设计为独立模块,并通过FastAdmin的钩子机制挂载到表单提交、评论发布等关键节点。管理员可通过后台界面动态更新敏感词库、调整过滤强度,甚至启用AI学习反馈机制——将人工审核结果反哺模型训练,持续优化AI内容的“价值观对齐”能力。这种闭环管理方式,有助于系统在合规与用户体验之间取得平衡。

当然,技术手段并非万能。再完善的过滤系统也无法完全替代人工审核与制度建设。尤其在涉及政治、宗教、性别等高度敏感领域时,仍需建立多级审核流程和应急响应机制。FastAdmin提供的日志记录与操作审计功能,可帮助追踪内容发布轨迹,为事后追责提供依据,进一步强化AI内容的“价值观对齐”保障体系。

综上所述,面对AI内容的“价值观对齐”难题,技术防控是不可或缺的一环。通过在FastAdmin中科学设置“内容红线过滤器”,不仅能提升平台内容安全性,还能增强用户信任与品牌公信力。未来,随着AI伦理规范逐步完善,此类技术实践将成为数字内容治理的标准配置。开发者应主动拥抱责任,将价值观引导融入产品设计,真正实现技术向善。

后台体验地址:https://demo.gzybo.net/demo.php

移动端体验地址:https://demo.gzybo.net/wx

账号:demo

密码:123456

联系我们

发表评论 取消回复