在互联网信息爆炸的时代,内容采集成为了许多网站快速获取信息的重要手段。FastAdmin作为一款优秀的开源后台管理系统,其自动采集文章功能可以帮助用户高效地获取大量文章。然而,内容重复是自动采集过程中不可避免的问题,这不仅会影响网站的质量和用户体验,还可能导致搜索引擎对网站的降权处理。那么,如何在使用FastAdmin自动采集文章时有效避免内容重复呢?

选择多样化的数据源

FastAdmin支持从多个不同的数据源采集文章,在选择数据源时,应尽量选择内容丰富、更新及时且差异化较大的网站。例如,不要只从一两个热门资讯网站采集文章,而是可以涵盖行业垂直网站、专业论坛、博客等多种类型的站点。这样可以确保采集到的文章在主题、观点和表述上具有多样性,降低内容重复的概率。

利用采集规则过滤重复内容

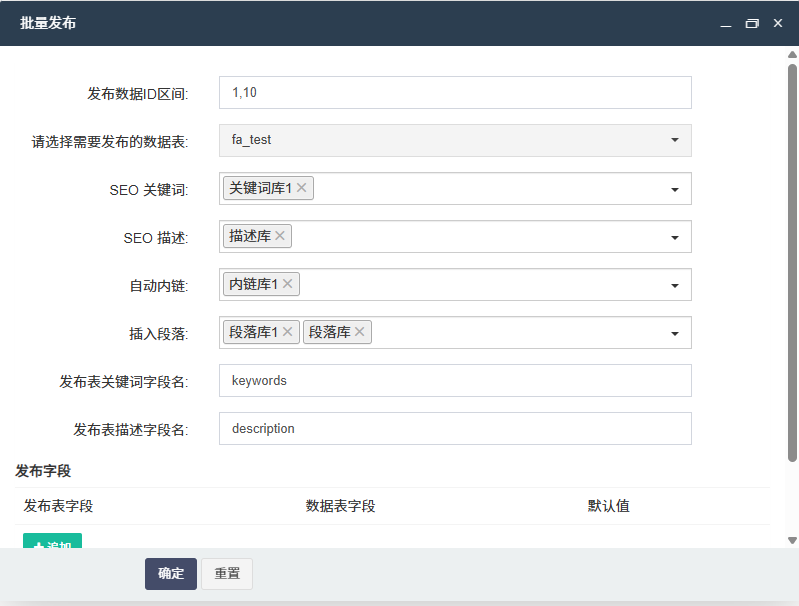

FastAdmin提供了强大的采集规则设置功能。在设置采集规则时,可以通过筛选条件来过滤掉已经采集过的文章。比如,可以根据文章的标题、URL、发布时间等信息进行筛选。如果发现标题或URL与已采集的文章相同,就跳过该文章,避免重复采集。同时,还可以设置采集的时间范围,只采集最新发布的文章,这样也能在一定程度上减少重复内容的出现。

对采集内容进行智能处理

采集到的文章可能存在大量的重复段落或表述,这时可以利用FastAdmin的内容处理功能对文章进行智能处理。例如,使用同义词替换、句子重组等方法对文章进行改写。可以通过编写脚本或使用第三方工具,将文章中的一些常用词汇替换为同义词,调整句子的语序,使文章在保持原意的基础上,呈现出不同的表达方式。但要注意,改写过程中要保证文章的质量和可读性,避免出现语句不通顺或表意不明的情况。

人工审核与筛选

虽然FastAdmin的自动采集功能可以提高效率,但人工审核仍然是必不可少的环节。安排专人对采集到的文章进行审核,筛选出重复、低质量或不符合网站定位的文章。人工审核可以从内容的深度、广度、独特性等多个方面进行综合评估,确保最终发布的文章具有较高的质量和价值。同时,人工审核还可以发现一些自动采集规则无法识别的重复内容,进一步提高内容的原创性。

建立文章库与查重机制

建立一个属于自己的文章库,将采集到的文章存储在文章库中。在每次采集新文章时,先对文章库进行查重,检查新文章是否与库中的文章存在重复。可以使用一些专业的查重工具,如CopyLeaks、PlagScan等,这些工具可以快速准确地检测出文章中的重复部分。通过建立文章库和查重机制,可以有效地避免重复文章的发布,提高网站的内容质量和搜索引擎排名。

在使用FastAdmin自动采集文章时,通过选择多样化的数据源、利用采集规则过滤重复内容、对采集内容进行智能处理、人工审核与筛选以及建立文章库与查重机制等方法,可以有效避免内容重复,为网站提供高质量、原创性的文章,提升网站的竞争力和用户体验。

后台体验地址:https://demo.gzybo.net/demo.php

移动端体验地址:https://demo.gzybo.net/wx

账号:demo

密码:123456

联系我们

发表评论 取消回复